[Cloudera - 10] pyspark 쉘에서 HDFS 파일 wordcount

[Cloudera - 10] pyspark 쉘에서 HDFS 파일 wordcount

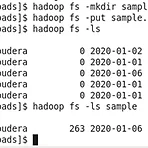

이전 글에서 사용했던 여러 함수들을 사용해 간단한 예제 텍스트 파일을 HDFS에서 불러와 wordcount를 직접 해보겠습니다. 먼저 아래 링크에서 sample.txt 파일을 가상머신 내부에 설치해줍니다. 파일 링크http://ailab.ssu.ac.kr/rb/?c=8/29&cat=2016_1_%EB%B9%85%EB%8D%B0%EC%9D%B4%ED%84%B0%EB%B6%84%EC%82%B0%EC%BB%B4%ED%93%A8%ED%8C%85&uid=797 A.I Lab - Spark #1 강의자료관리자 | 2016.05.09 | 조회 591ailab.ssu.ac.kr sample.txt 파일이 있는 Downloads 디렉터리로 들어가서 파일을 HDFS에 put 해줍니다. 이제 pyspark 쉘에 들어가서 ..

[Cloudera - 4] HDFS 데이터를 Hive로 옮기기

[Cloudera - 4] HDFS 데이터를 Hive로 옮기기

저번 글에서 MYSQL 데이터를 HDFS로 옮겨봤는데요이번에는 옮겨던 HDFS 데이터를 다시 Hive로 옮겨보겠습니다. 저번에 HDFS로 import해서 가져온 데이터입니다. hive 라고 입력하면 hive cli로 변경됩니다. 먼저 hdfs_retail_db라는 database를 만들어줍니다. 그리고 categories라는 테이블을 만들고 HDFS에 있는 데이터와 동일한 데이터 타입으로 각 column을 다음과 같이 정의합니다. load data inpath 'HDFS에서 옮기려는 데이터' into table 테이블이름 으로 입력해줍니다. 다음 쿼리를 통해 HDFS에서 Hive로 성공적으로 데이터를 옮긴 것을 확인할 수 있습니다.

[Cloudera - 3] Sqoop으로 MYSQL에서 HDFS로 import하기

[Cloudera - 3] Sqoop으로 MYSQL에서 HDFS로 import하기

Sqoop은 MYSQL, Oracle, Postgresql과 같은 RDBMS와 HDFS, Hive, Hbase와 같은 하둡 에코시스템 사이에서 데이터를 주고 받을 수 있게 해줍니다. 이번 글에서는 MYSQL에서 HDFS로 스쿱을 사용해 데이터를 import하는 방법에 대해 알아보겠습니다. 먼저 quickstart에 설치되어있는 MYSQL에 접속하기위해 mysql -u root -p를 입력하고 패스워드는 cloudera를 입력해줍니다.show databases를 해보면 이미 여러 database가 있는 것을 확인할 수 있습니다. 이번에 사용할 데이터는 retail_db라는 database에 있는 테이블을 사용합니다.use retail_db로 retail_db를 선택하고 show tables를 통해 들어있는..

[Hadoop] HDFS

[Hadoop] HDFS

HDFS(Hadoop Distributed File System)는 하둡의 핵심 구성요소의 하나로써 데이터를 분산하여 저장시키는 파일 시스템 입니다. HDFS는 하나의 Name node(Master)와 여러대의 Data node(Slave)로 구성되어 있으며 file을 Block으로 분할하여 각 Block들을 Data node에 분산시켜 저장합니다.Block의 사이즈는 기본 65MB 혹은 128MB이며 file이 block의 크기보다 작을 때는 block 크기 전체를 사용하지는 않습니다. 이 때 Block은 복제되어 복제된 block들이 여러 노드에 하나씩 저장됩니다.default값은 3개이며 수정할 수 있습니다. 그리고 Name node에는 각 Bloock들이 어디에 위치해 있는지에 대한 정보를 포함..

- Total

- Today

- Yesterday

- 하이브

- python

- Django

- 삼각형 위의 최대 경로

- 합친 lis

- 출전 순서 정하기

- C++

- 외발 뛰기

- 코딩인터뷰 완전분석

- 알고스팟

- 종만북

- Hadoop

- 분할정복

- 배열과 문자열

- Sqoop

- 2225

- 하둡

- HiveQL

- import

- 스파크

- Jaeha's Safe

- pyspark

- 삼각형 위의 최대 경로 수 세기

- hive

- microwaving lunch boxes

- HDFS

- 두니발 박사의 탈옥

- 팰린드롬 구하기

- 완전탐색

- 백준

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |